No post anterior, foi-se explicitado como a utilização da Inteligência Artificial auxilia e inova o emprego do Direito. Porém, é de suma importância ter um olhar crítico quanto à esta tecnologia, se afastando da visão ultrarromântica.

A modernização de uma máquina, que aprende novas soluções a partir de sua própria execução, traz autonomia e até uma certa imprevisibilidade das ações geradas por algumas I.A’s. Ademais, o seu advento possibilitou os meios necessários para afastar condutas da identidade individual do seu usuário ou desenvolvedor.

Por exemplo, ilustra-se o fenômeno dos V-Tubers (youtubersque se utilizam de avatares digitais gerados por computação gráfica, que podem alterar feições e a voz) e um caso em 2018 no Japão, em que fãs da V-Tuber Nora Cat descobriram que “ela” seria, na verdade, um homem através de um erro no seu software.

Neste post, iremos destrinchar brevemente o outro lado da Inteligência Artificial, quando esta é utilizada para auxiliar na prática de atos ilícitos.

DEEPFAKES

Celebridade na época de eleições, pandemia COVID-19 e conversas familiares nas reuniões de domingo, a Fake News é um elemento intrínseco à cultura digital. As notícias inverossímeis sempre ocorreram, porém é inegável que o interesse de “fabricá-las” em massa, para se atingir alguma meta, se tornou popular por conta da facilidade algorítmica e a liberdade de divulgação de quaisquer conteúdo on-line, em especial nas redes sociais.

Tenha-se em mente (Pode ser feita a seguinte analogia, a Fake News em si seria um roteiro e a Deepfake a produção cinematográfica do filme, baseado neste roteiro.) a Fake News como um roteiro e a Deepfake como a produção cinematográfica deste. Através da manipulação de imagem, som e vídeo de maneira absurda, as deepfakes conseguem tornar uma notícia falsa, de forma que é quase impossível de se perceber em uma leitura artificial.

O intuito, na verdade, é refinar e sofisticar a adulteração de notícias verdadeiras, visto que a disseminação Fake News, mesmo que das mais precárias, tem um enorme poderde decidir eleições governamentais, por exemplo, como pôde ser observado ao redor do mundo nas últimas eleições presidenciais.

O avanço da tecnologia de Inteligência Artificial foi o responsável porproporcionar estes meios sofisticados de manipulação de vídeo, áudio e imagem. E este desenvolvimento, como enxergamos ao redor, é desenfreado. Por exemplo, atualmente, consegue-se até clonar a voz de uma pessoa em apenas 5 segundos de conversa. O que será que poderemos fazer daqui a 2 anos?Logo, um dos maiores riscos ilícitos com auxílio de I.A. é a circulação volumosa de deepfakes visto que a tendência é tornar esta tecnologia cada vez mais acessível e barata.

OUTRAS FORMAS DE CIBERATAQUES

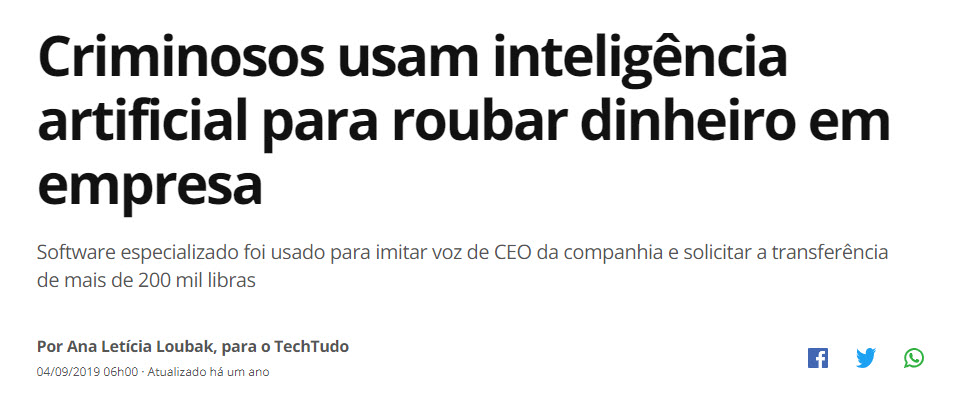

A adulteração de voz não serve apenas para a divulgação em massa de deepfakes. Como visto na notícia acima, criminosos usufruem deste conhecimento para inovar golpes antigos como a fraude, extorsão, falso sequestro e roubos.

A Inteligência Artificial além de prover os meios, também, acoberta e torna o crime lucrativo, de certa forma. Afinal, esta inovação possui uma estrutura complexa de detecção e por se tratar de um crime virtual com alto índice de compartilhamentos, certos golpes são até vendidos como se fossem um tipo de serviço.

RECONHECIMENTO FACIAL

A Inteligência Artificial, na gama de suas diversas ferramentas, apresenta o reconhecimento facial. É dessa forma que é possível o Facebook sugerir que você marque seu colega exatamente no rosto dele apresentado na foto em grupo que irá postar. E constantemente nós atualizamos o nosso reconhecimento facial, ao se utilizar de testes (O famoso “Qual seria a sua aparência se você fosse do gênero oposto?”) ou fotos do Facebook, confirmações de contas no banco e por câmeras públicas que permitem o monitoramento policial.

(notícia escrita por Aliny Gama, colaboração para o site UOL em 26/02/2020 às 13h31)

O perigo mora na técnica de policiamento preditivo, o qual é um sistema gerado por Inteligência Artificial que pretende prever onde um crime pode ocorrer e até quem poderá estar envolvido nele. Para chegar neste resultado, é necessário que se alimente o sistema com dados baseados nos lugares – se utiliza aqueles que possuem um maior índice de ocorrência de delitos – e em perfis pessoais – dados pessoais dos agentes que foram presos anteriormente. Simples, rápido e feito de forma neutra, não?

De fato, hoje em dia atribuir certos dados em um sistema é um processo simples e as previsões geradas por estes seriam feitas de maneira célere. Porém, seria um equívoco afirmar que este processo é realizado de uma visão neutra, que não carrega aspectos morais e preconceitos. Afinal, os dados seriam atribuídos pelos próprios policiais que em seu inquérito, experiência de ofício veio a deter seu próprio método pessoal para solucionar o crime, embasado em seus valores e crenças.

Neste momento, é importante frisar a utilização de criminalização secundária nestes sistemas. Conceito elaborado pelos doutrinadores de Direito Penal: Nilo Batista e Eugenio Zaffaroni, sendo esta a atribuição da execução de certos crimes à um grupo a partir de estereotipação social do criminoso, recorte negativo respaldado por divulgação midiática. Este fenômeno ocorreu devido a capacidade escassa de apreensão de criminosos por parte das delegacias, por isso se faz esta pré-seleção.

Dessa forma, o policiamento preditivo pode vir a reforçar estereótipos na sociedade, mesmo não sendo feita de forma intencional e, consequentemente, vir a auxiliar naexecução apreensões injustas.

ÉTICA

Para definir o embate ético que decorre ao uso de inteligência artificial, irei responder dois questionamentos pertinentes realizados pela professora Bianca Kremer:

O que se considera como um problema? Quais são os valores embutidos para solucionar este problema?

Entende-se que as inovações tecnológicas derivam de demandas da sociedade, pela busca de soluções de problemas. No entanto, a definição de “problema” pode variar muito de acordo comdiferentes culturas, idades, interesses pessoais e até mesmo gestão de países. Por exemplo, o terrorismo é um problema contemporâneo e a utilização de reconhecimento facial auxiliaria a solução deste problema. Mas como se define o perfil de um terrorista? Para o Governo Chinês, a religião é um critério essencial e a partir deste pretexto, utiliza de reconhecimento facial para perseguir minorias muçulmanas, da etnia uigure, em sua região ocidental. Dessa forma, pode-se concluir que para o Governo Chinês, ser muçulmano faz parte do problema o que desencadeia a violação de uma série de direitos fundamentais. Dessa maneira, como solução do problema é preciso tomar cuidado com a falsa pretensão de que a tecnologia é desenvolvida e realizada para a universalidade, supostamente embrenhada de responsabilidade social.

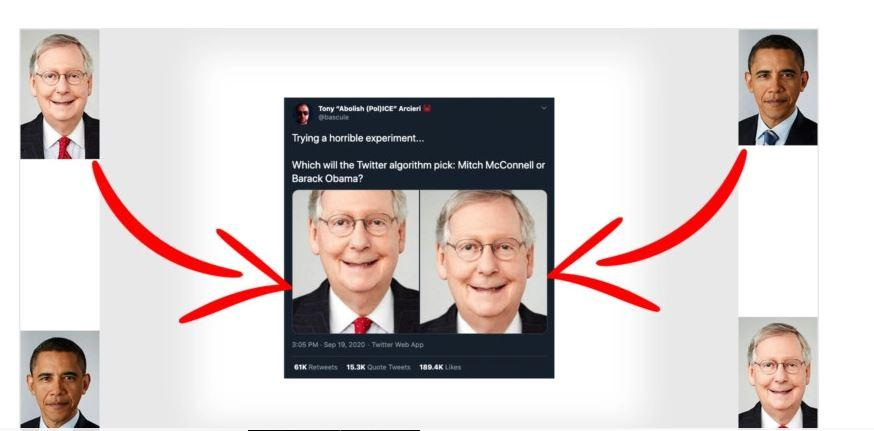

Como explicitado no tópico de reconhecimento facial, a criação ou o uso de uma Inteligência Artificial parte por esses algorítmicos, que de forma não intencional reforçam valores individuais. Ainda nesta esteira, temos como exemplo a polêmica recente envolvendo o Twitter,quanto à priorização de seu algoritmo em fotos que apresentam pessoas brancas em detrimento de negras. Em outras palavras, caso fosse postada uma foto com duas pessoas, uma branca e uma preta, nas extremidades do quadro, somente seria mostrado na timeline o rosto da pessoa branca, dentro do espaço disponível para mídias dentro do tweet.

Contudo, não podemos descartar a possibilidade de que estes valores sejam atribuídos aos algoritmosde forma intencional, tendo por finalidade uma manutenção da hierarquia sociale reprodução de valores preconceituosos e nocivos da sociedade, em detrimento das minorias ou grupos mais vulneráveis.

ANTICONCORRENCIAL

Monitorar a concorrência, acumular dados de consumidores e fornecedores em apenas um clique. Atribuir decisões estratégicas dentro de uma empresa nunca foi tão fácil devido ao emprego de inteligência artificial. Aliás, também nunca se teve tanta facilidade para cometer práticas anticompetitivas de mercado.

Os usos ilícitos comuns de Inteligência Artificial no ambiente concorrencial são mais frequentesna elaboração refinada de discriminação de preços e a possibilidade de se acordar à praticar um ato anticompetitivo fora do “radar” do Conselho Administrativo de Defesa Econômica (CADE).

Quanto aos preços, primeiramente, expõe-se que a otimização gerada pela Inteligência Artificial com a possibilidade de monitoramento da concorrência, possui resultados parecidos com cartéis tradicionais de preços supracompetitivo, entre outras elaborações refinadas de discriminação de preços.

Ainda se referindo ao valor monetário de um produto, através de big data, as empresas conseguem estipular um perfil comportamental do consumidor. Dessa forma, emprega-se uma propaganda específica quanto aos perfis individuais que venham a mostrar preços diferentes sobre um mesmo produto.

Atualmente, a obtenção massiva de dados se tornou uma nova dimensão de lucro e nota-se que grandes plataformas como Google, Amazon e Facebook se encontram em posições deslealmente privilegiadas em relação com as outras empresas. Cabe salientar, também, que as empresas podem manipular seus algoritmos para que a Inteligência Artificial aja de maneira anticoncorrencial de formas diversas. Como por exemplo, o caso de 2017 o qual a Google foi acusada de favorecer vídeos do seu conglomerado, como Youtube e outros serviços seus em detrimento de outros sites.

RESPONSABILIDADE JURÍDICA

Não há como pontuar todas as novas demandas ocasionadas pela imersão das atividades realizadas por Inteligência Artificial, este leque varia entre temas de Direito Autoral, Direito Concorrencial, Direito Internacional, Direito Penal e entre estes, a necessária discussão sobre Responsabilidade Jurídica da Inteligência Artificial.

Existe a possibilidade de uma Inteligência Artificial possuir responsabilidade jurídica por conta de suas ações ilícitas? Ou seria o desenvolvedor da IA o responsável?O elevado grau de independência destes sistemas resultam em ações proporcionalmente imprevisíveis, logo, poderia o usuário ou o programador alegar a imprevisibilidade para se isentar de eventual responsabilidade?

A questão é que há uma lacuna no ordenamento brasileiro, colocando em xeque os elementos tradicionais de responsabilidade jurídica, que não se atém a estas complexidades. Como qualificar culpa em uma Inteligência Artificial? A Inteligência Artificial precisaria possuir algum tipo de personalidade jurídica para responder por suas ações? Como diferenciar uma conduta imprevisível de um erro técnico de programação ou manutenção do sistema?Como identificar que aquela conduta errante da máquina seria efetivamente criminosa? Seria justo, também, o fabricante da I.A. responder por todas as suas ações?

Todas estas questões permanecem sem resposta, cabendo ao legislador brasileiro observar a necessidade de criação de legislação a fim de sanar todos estes questionamentos, trazendo maior segurança, inclusive, jurídica para o universo das IAs no Brasil.

Comentários